Штучний інтелект уперся в стелю: кількість використовуваних для навчання даних обмежена, і вони швидко закінчуються. У зв’язку з цим стартапи вдаються до допомоги синтетичних даних — інформації, згенерованої іншими нейромережами.

ШІ-стартап Anthropic застосував синтетичні дані для навчання однієї зі своїх флагманських моделей Claude 3.5 Sonnet. Meta допрацювала свої нейромережі Llama 3.1 за допомогою створених ШІ даних. OpenAI також застосовує синтетичну інформацію для навчання o1 — штучного інтелекту, що «міркує».

TechCrunch звернули увагу на переваги та недоліки такого підходу.

Анотація

Системи штучного інтелекту — це статистичні машини. Вони навчаються на великій кількості прикладів і вивчають закономірності для подальших прогнозів.

Анотації — текстові мітки, що позначають сенс або частини даних — є ключовим елементом у цих прикладах. Вони слугують орієнтирами, «навчаючи» модель розрізняти предмети, місця та ідеї.

Наприклад, якщо нейромережі показати безліч фотографій кухні та позначити їх словом «кухня», з часом вона почне асоціювати її загальні характеристики на кшталт наявності холодильника або стільниці. Після навчання модель зможе розпізнати фотографію кухні, яку раніше їй не показували.

У процесі навчання важливо грамотно класифікувати анотації. Наприклад, якщо зображення з кухнями позначати словом «корова», ШІ пов’язуватиме холодильник із твариною.

Необхідність застосування помічених даних створила цілий ринок анотаційних послуг, який оцінюють у $838,2 млн, а протягом 10 років досягне $10,34 млрд.

У деяких випадках маркування даних вимагає спеціалізованих знань і досвіду, наприклад, якщо це стосується математики. Існують фірми, що спеціалізуються на анотації даних. Робота в таких компаніях може бути як високооплачуваною, так і навпаки. У країнах, що розвиваються, працівники отримують менше ніж $2 на годину.

Потрібно замінити людей

Платити маркувальникам даних іноді дорого, плюс вони здатні помилятися. Також саме отримання інформації може бути витратним. Shutterstock стягує десятки мільйонів доларів з ШІ-постачальників за доступ до своїх архівів. Reddit заробив сотні мільйонів на ліцензуванні інформації для Google, OpenAI та інших.

Нарешті, дані стає все важче отримати. Понад 35% з 1000 найкращих веб-сайтів блокують доступ для OpenAI. Якщо тенденція збережеться, ШІ здатний вичерпати всю загальнодоступну інформацію до 2026-2032 років.

Усе це, а також ризики судових позовів за використання ліцензованої інформації, призвело до необхідності генерувати синтетичну інформацію.

Синтетичні альтернативи

Якщо дані — це нафта, синтетична інформація позиціюється як біопаливо, яке можна створити без негативних зовнішніх наслідків, зазначив кандидат наук Вашингтонського університету Ос Кіз.

«Ви можете взяти невеликий стартовий набір даних і моделювати та екстраполювати нову інформацію з нього», — зазначив він.

ШІ-індустрія взяла технологію на озброєння і почала застосовувати. У грудні компанія Writer представила модель Palmyra X 004, навчену майже повністю на синтетичних даних. Розробка обійшлася в $700 000 порівняно з $4,6 млн, які витратив OpenAI за створення нейромережі аналогічного розміру.

Відкриті моделі Phi від Microsoft частково навчалися на синтетичних даних, так само як і Gemma від Google. Цього літа Nvidia представила сімейство моделей, призначених для створення синтетичної навчальної інформації, а ШІ-стартап Hugging Face випустив «найбільший» набір інформації для налаштування ШІ, що складається зі штучного тексту.

Генерація синтетичних даних стала бізнесом, вартість якого може зрости до $2,34 млрд до 2030 року.

Синтетичні ризики

Застосування синтетичних даних несе в собі певні ризики. Якщо інформація, що застосовується для створення штучних відомостей, має упередженість або обмеження, результат буде зіпсований.

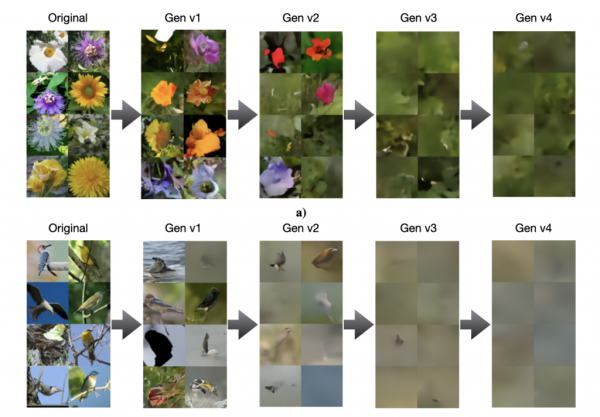

Надмірне застосування синтетичних даних під час навчання нейромереж призводить до зниження якості та різноманітності моделі, йдеться в дослідженні Університетів Райса і Стенфорда.

Великі нейромережі на кшталт o1 здатні створювати більш складні для виявлення галюцинації, що призведе до зниження точності ШІ, навченого на подібних даних.

Опубліковане в липні дослідження показує, що моделі, навчені на помилкових даних, генерують ще більш неправдиву інформацію. Це створює петлю деградації для наступних нейромереж. Згодом штучний інтелект може давати відповідь, узагалі ніяк не пов’язану із запитанням.

Інше дослідження наочно показало зниження якості роботи моделі на прикладі зображень.

Джерело: TechCrunch.

Старший науковий співробітник Інституту штучного інтелекту Аллена Лука Солдайні вважає, що застосування синтетичних даних доцільне в разі їхньої ретельної перевірки, фільтрації та зіставлення з реальною інформацією.

Недотримання цієї вимоги може призвести до краху моделі, вона стане менш «творчою» і більш упередженою у своїх висновках, що в кінцевому підсумку серйозно знизить її функціональність.

«Конвеєри синтетичних даних не є самодосконалими машинами. Їхні результати мають бути ретельно перевірені й поліпшені, перед їхнім використанням для навчання», — зазначив він.

Раніше CEO OpenAI Сем Альтман зазначив, що коли-небудь ШІ буде створювати синтетичні дані, досить хороші для ефективного самонавчання.

Нагадаємо, у грудні співзасновник OpenAI Ілля Суцкевер спрогнозував кінець епохи попереднього навчання штучного інтелекту і передбачив появу суперінтелекту.